Und wieder ist eine Woche der Nischenseiten-Challenge rum. Irgendwie scheint die ganze Geschichte etwas zu stagnieren, zumindest, was die Geld-Einnahmen betrifft. Das war ja eigentlich das erklärte Kriterium der Veranstalter für den Erfolg in der Challenge. Diesbezüglich hat sich auf meiner Nischenseite nichts wesentliches getan, was aber für mich (momentan) auch nicht ganz so im Mittelpunkt steht. Wenn du meine Wochenberichte zur Nischenauswahl gelesen hast, weißt du, wie ich das sehe.

Wichtiger ist für mich der weitere Trafficaufbau, allerdings gab es auch da keine nennenswerten Entwicklungen. Das liegt aber vor allem daran, dass ich letzte Woche nur wenig Zeit in die NSC investieren konnte. 13 Wochen sind halt doch etwas knapp für den Aufbau einer Nischenseite nach meinen Kriterien.

Weitere Inhalte erstellen

Eine der wichtigsten Arbeiten an der Nischenseite ist die kontinuierliche Erstellung der Inhalte. Manch einer wird jetzt sagen: Das ist ja nun nichts Neues! Ist es auch nicht, hat nur glücklicherweise (wieder) eine größere Bedeutung bekommen.

Allerdings weicht meine Methode ein bisschen von der traditionellen Herangehensweise, wie sie auch von vielen Teilnehmern der Nischenseiten-Challenge praktiziert wird, ab. Das hängt nicht zuletzt mit meinem Verständnis einer „Nischenseite“ zusammen. Meine grundsätzliche Vorgehensweise dazu hatte ich in den Wochenberichten 3 und 4, sowie 7 in groben Zügen umrissen:

- Wichtigste „Mitspieler“ in der Nische und deren aktuelle Aktivitäten identifizieren,

- Eine Longtail-Keywordliste (400-500) aufbauen, die auf den 20 häufigsten Suchbegriffen der Nische basiert und mir hilft, eine Strukturierung der Nischenseite zu finden.

Was hat das alles nun mit meinem Content zu tun? Um das zu erläutern, muss ich etwas weiter ausholen.

Nischen-Marketing ist für mich heutzutage eindeutig Content-Marketing. Wertvoller, interessanter, unterhaltsamer Content, zielgerichtete Informationen, das ist das, was von den Lesern gesucht wird und was Suchmaschinen wie Google anbieten müssen und wollen. Der schöne „Zusatz“-Effekt für Internetmarketer: die Monetarisierung ergibt sich fast von alleine.

Content=SEO –> so einfach (und so kompliziert) ist das.

Das Curation-Modell

Wesentlicher Bestandteil meiner Content-Strategie ist das sogenannte Curation-Modell . Die deutsche Entsprechung Kuration (lat. curare „pflegen“,“sich sorgen um“) wird im Sinne von „Bewahren“ und „Behandeln“ verwendet. Verwandte Begriffe sind z.B. Kurator, Kur, Kuratorium…

Das trifft das Wesen des Begriffes „Curation“ in der Verbindung Content-Curation eigentlich ganz gut. Trotzdem verwende ich lieber den englischen Originalbegriff „Curation“. Content-Curation ist eigentlich nichts Neues, wird aber oft missverstanden und falsch angewendet.

Content-Curation hat nichts zu tun mit Autoblogging oder „Webseitenklau“. Der “ Curator „, also der Nischenseiten- oder Blogbetreiber, filtert quasi die Ressourcen seiner Nische für seine Zielgruppe, trägt die (seiner Meinung nach) wertvollsten Inhalte zusammen, kommentiert die Quellen, steuert eigene Gedanken bei und versucht so, seinen Lesern das Beste anzubieten, was im Netz zu finden ist. Das Ziel ist nicht, dem ohnehin überreichlich vorhandenen Content neue Teile hinzuzufügen, sondern den qualitativen Content der Nische seinen Interessenten (subjektiv aufbereitet) zugänglich zu machen.

Content-Curation funktioniert für jede Nische, für jedes Thema, für jeden Blog. Bei entsprechender Organisation von Beginn an schaffst du dir damit praktisch eine unerschöpfliche Content-Quelle, die dir auf Monate und Jahre hinaus den nötigen Stoff liefern kann. Sei es in Form von Texten, Reporten, Videos oder Produkten und Dienstleistungen, die zu deiner Nische passen.

Die formale Umsetzung ist nicht schwierig, obwohl es ein paar Stolpersteine gibt und auch der Zeitaufwand (in der Startphase) beträchtlich sein kann. Wichtig ist die Systematik beim Abarbeiten der einzelnen Schritte.

Ermitteln relevanter URL bzw. Domains

Im Wochenbericht 7 hatte ich erläutert, wie ich meine Master-Keywordliste erarbeitet habe. Zu diesen Keywords brauche ich diejenigen Webseiten, die jeweils auf den ersten Plätze der Suchergebnisse auftauchen.

Du kannst dir sicher vorstellen, dass das Ermitteln tausender relevanter URL und deren Aufbereitung je nach Umfang der Master-Keywordliste ziemliche Dimensionen annehmen kann. Das ist also eine typische Aufgabe, die automatisierungsfähig ist.

Desktop-Tool „Scrapebox“

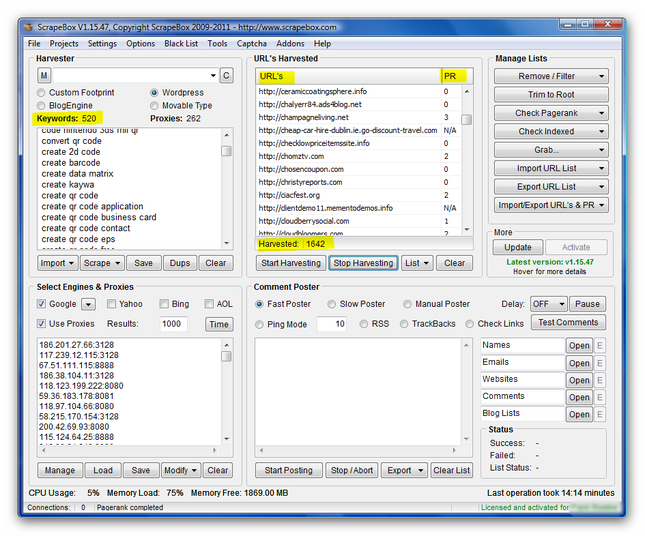

Ich nutze für das Sammeln der URL das Desktop-Tool “ Scrapebox „, das mit einer Vielzahl von Funktionen daherkommt und ständig weiterentwickelt wird. Ursprünglich als SEO-Tool hauptsächlich zur automatischen Kommentierung von Blogposts entwickelt (und deshalb fälschlicherweise ein bisschen als Spammer-Tool verschrien), verwende ich die “ Scrapebox “ für viele Off-Page-SEO-Aufgaben, wie für das beschriebene URL-Sammeln, Wettbewerber-Analyse, zusätzliche Keyword-Research, Backlink-Aufbau usw.

Tipp : Über diesen Link hier erhältst du übrigens völlig legal und ohne irgendeine Gegenleistung einen satten Preisrabatt von über 40% auf die Software!

Der Screenshot zeigt das Ergebnis des URL „harvestens“ mit Scrapebox, einschließlich der zugehörigen Domain-Pageranks auf der Basis meiner 520 Master-Keywords. Die ursprüngliche URL-Liste wurde noch bereinigt und auf die jeweilige TLD reduziert. Damit stehen mir jetzt 1.642 relevante URL (aus dem Index von Google) für die weitere Arbeit zur Verfügung.

Wenn du mehr über die “ Scrapebox “ und ihre unglaublichen Möglichkeiten erfahren willst, empfehle ich dir wärmstens das einzige mir bekannte deutschsprachige Scrapebox-Handbuch, den Scrapebox-Master-Guide von Kay Molkenthin . Absolut zu empfehlen für jeden, der sich zunächst einen fundierten Überblick über die Software verschaffen will oder auch schon damit arbeitet. Auf über 130 Seiten und mit 91 Abbildungen sowie ausführlichen Schritt-für-Schritt-Anleitungen lernst du alle Funktionen der Scrapebox bis ins Detail kennen und erhältst viele zusätzliche Informationen zu effektiven SEO-Maßnahmen.

Der nächste Schritt ist das Prüfen jeder einzelnen dieser Domains, die zum jeweiligen Keyword auf den ersten Plätzen rangieren. Daraus werden dann die RSS-Feeds gezogen und im Google-Reader abonniert. Die aktuellen Feeds der ranking-stärksten Webseiten sind dann letztendlich die Basis für das Schreiben meiner Artikel nach dem Curation-Modell.

Parallel dazu beginnt je nach Möglichkeiten der schrittweise Backlinkaufbau z.B. durch Kommentare oder Forenbeiträge und durch Social Media.

Wie ich das Curation-Modell im Einzelnen realisiere und was dabei nach meiner Erfahrung am Besten funktioniert, werde ich nach Abschluss der Nischenseiten-Challenge in einem kleinen Extra-Report zusammenfassen und meinen Lesern zur Verfügung stellen.

Wenn du zu gegebener Zeit über das Erscheinen des Reports informiert werden möchtest, trage dich doch einfach unverbindlich hier unten in meine Liste ein. Du erhältst dann ein kostenloses Exemplar, sobald es verfügbar ist.